V štvrtej časti seriálu o vysvetliteľnej umelej inteligencii si priblížime, aké komponenty a vlastnosti by mali mať dobré vysvetlenia rozhodnutí modelov umelej inteligencie.

Z pohľadu strojového učenia (ang. machine learning, ML) žijeme šťastné časy. Pre mnohé úlohy, ktoré sme doteraz nevedeli s pomocou umelej inteligencie uspokojivo vyriešiť, poznáme nie jednu, ale hneď viacero rôznych metód alebo modelov strojového učenia. Z nich si môžeme vybrať a dosiahnuť tak aspoň akceptovateľné výsledky. Toto množstvo modelov, spôsobov spracovania dát, ich variácií a možných kombinácií predstavuje výzvu: musíme nájsť takú konfiguráciu, ktorá vyhovuje našej úlohe a dátam.

Vymedzenie kritérií

Aby sme našli správny model, musíme definovať kritériá, ktoré merajú, ako dobre konkrétny model a jeho parametre aj hyperparametre adresujú daný problém. Často používanými kritériami sú (v závislosti od úlohy) napríklad presnosť, správnosť, úplnosť, F1 skóre alebo kvadratická chyba.

V ďalšom kroku zvyčajne vykonáme optimalizáciu tzv. hyperparametrov. Pri tom sa snažíme nájsť dobrú konfiguráciu modelu (napríklad architektúru neurónovej siete) a postupnosť krokov predspracovania a následného spracovania dát. Ak máme k dispozícii dostatočné prostriedky, môžeme využiť automatizované strojové učenie (Automated ML, AutoML), prostredníctvom ktorého možno nájsť vhodnú konfiguráciu s pomocou rozumného prehľadania množiny všetkých možných konfigurácií hyperparametrov.

Vďaka pozornosti, ktorá sa v posledných rokoch venuje vysvetliteľnému strojovému učeniu, sa stal počet metód vysvetliteľnosti podobne ohromujúci ako počet rôznych metód strojového učenia. Ak chceme napríklad poskytnúť používateľom dobré vysvetlenia rozhodnutí komplexného modelu, musíme nájsť nielen správnu metódu vysvetliteľnosti, ale aj jej konkrétnu konfiguráciu.

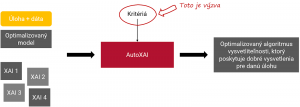

Aby sme takúto konfiguráciu našli, môžeme si požičať niektoré koncepty z AutoML. Podobne ako pri ňom máme na vstupe priestor dostupných metód vysvetliteľnosti a ich rôznych konfigurácií. Takýto priestor však môže byť obrovský a potenciálne nekonečný. Aj keby sme chceli vybrať najlepšiu metódu len z dvoch rôznych metód, z ktorých každá má tri parametre s tisícom rôznych hodnôt, musíme brať do úvahy 6 000 rôznych možností. V skutočnom svete býva tento priestor značne väčší.

Na výstupe chceme dostať takú konfiguráciu, ktorá nám bude poskytovať dobré vysvetlenia pre našu kombináciu úlohy, modelu a dát. V takomto prípade môžeme hovoriť o automatizovanej vysvetliteľnej umelej inteligencii alebo AutoXAI. Náročnou časťou AutoXAI je zadefinovať, ako porovnávať rôzne metódy vysvetliteľnosti. Inými slovami – čo znamená dobré vysvetlenie?

Vernosť a zrozumiteľnosť

Podľa viacerých autorov (napr. Zhou, J. a kol., 2021; Markus, A. F., Kors, J. A., Rijnbeek, P. R., 2021) by dobré vysvetlenie malo hľadať rovnováhu medzi dvoma komponentmi. Malo by verne opisovať správanie modelu (vernosť, fidelity) a byť zrozumiteľné pre ľudí (understandability). Nejde o jednoduchú úlohu – zvýšenie zrozumiteľnosti môže v skutočnosti viesť k zníženiu vernosti a naopak.

Ak je vysvetlenie zrozumiteľné, ale chýba mu vernosť, mohli by sme skončiť s vysvetleniami, ktoré vyzerajú dobre alebo tak, ako by si to človek predstavoval, ale nemusia správne opisovať rozhodovací proces modelu. Znamená to, že vysvetlenie napríklad nemusí byť úplné. Môže v ňom chýbať informácia o tom, že nejaká časť vstupných dát významne ovplyvnila rozhodnutie modelu strojového učenia.

Na druhej strane, ak vysvetleniu chýba zrozumiteľnosť, môže používateľa zahltiť nadbytočnými informáciami, alebo môže byť také chaotické, že mu nebude rozumieť. Napríklad ak niektoré časti vstupu mali zanedbateľný vplyv na výslednú predpoveď modelu, môže byť kontraproduktívne zahrnúť takúto informáciu do vysvetlenia, ktoré sa poskytuje človeku.

Aby to nebolo také jednoduché, nie vždy platí, že medzi zrozumiteľnosťou a vernosťou musí byť rovnováha. Ak chceme napríklad použiť vysvetlenie na automatizované ladenie modelu (debugging) a identifikáciu chýb v ňom, vernosť vysvetlení bude dôležitejšia ako zrozumiteľnosť.

Správnosť a kompletnosť

Pre jednoduchosť sme sa doteraz obmedzili na dva komponenty vysvetliteľnosti – zrozumiteľnosť a vernosť. Poďme sa teraz pozrieť na jednu z možných taxonómií inšpirovanú prácami spomínaných autorov, ktorá poskytuje podrobnejší pohľad na vysvetliteľnosť. Ešte detailnejšiu taxonómiu požiadaviek na vysvetliteľné metódy, systémy a na rámce na ich vyhodnocovanie publikovali ďalší autori (Sokol, K., Flach, P., 2020).

Z pohľadu správnosti (soundness) sa pýtame, do akej miery je vysvetlenie pravdivé vzhľadom na model (a dáta), na ktorý sa viaže. Zameriavame sa na to, či vysvetlenie skutočne reflektuje iba správanie sa modelu. Vysvetlenie by teda nemalo zavádzať, nemalo by človeku hovoriť nič iné než pravdu. Niekedy sa pri implementácii metód vysvetliteľnosti, ako je napríklad oklúzna analýza, využívajú triky a optimalizácie, vďaka ktorým sú výpočtovo menej náročné. Pri tejto metóde namiesto toho, aby sme postupne mazali časti vstupu jednu po druhej a sledovali vplyv na predpoveď modelu, zmažeme viac častí naraz. Môže sa teda stať, že ak naraz odstránime časť, ktorá mala vplyv na predpoveď modelu a aj takú, ktorá vplyv nemala, finálne vysvetlenie o oboch týchto častiach povie, že ju významne ovplyvnili.

Kompletnosť (completeness) opisuje kvalitu vysvetlení z hľadiska toho, aká časť celého rozhodovacieho procesu a dynamiky modelu je zachytená daným vysvetlením. Pýtame sa, do akej miery vysvetlenie opisuje celý model (alebo dokonca systém). Chceme, aby nám vysvetlenie hovorilo nielen pravdu, ale celú pravdu.

Jasnosť, šírka a úspornosť

Jasnosť (clarity) hovorí o tom, že vysvetlenie by nemalo byť zmätočné a malo by byť jednoznačné. Okrem toho by pre podobné vstupy, pri ktorých sa aj samotný model rozhodoval podobným spôsobom, mali byť aj vysvetlenia podobné. V opačnom prípade takéto vysvetlenia nebude človek vnímať ako konzistentné.

Šírka (broadness) opisuje, na akú časť úlohy a dát je vysvetlenie možné aplikovať. Ako príklad si uvedieme hlbokú konvolučnú neurónovú sieť, ktorej úlohou je klasifikovať maľby maľované v rôznych štýloch. Od metódy vysvetliteľnosti požadujeme, aby nám objasnila, prečo neurónová sieť zaradila daný obraz do konkrétneho štýlu. Môže sa stať, že jedna a tá istá metóda vysvetliteľnosti bude schopná poskytnúť zmysluplné vysvetlenie len pre určitú skupinu obrazov. Napríklad pri moderných obrazoch, ktoré sa skladajú len zo základných geometrických tvarov, bude zdôvodnenie také, že sa na obraze nachádza veľké množstvo trojuholníkov, štvorcov či kruhov a žiadne iné tvary. Naopak, pri veľmi abstraktných dielach (napríklad na štýl Jacksona Pollocka) nebude metóda schopná poskytnúť nijaké zmysluplné vysvetlenie.

Na úspornosť (parsimony) sa vieme pozerať ako na aplikáciu princípu Occamovej britvy. Ako sme už ukázali na príklade, vysvetlenie by z pohľadu zrozumiteľnosti malo obsahovať iba tie detaily, ktoré prinášajú adresátovi (človeku) nejakú hodnotu. Malo by byť také jednoduché, ako sa len dá. Ak má vysvetlenie formu vety v prirodzenom jazyku, táto veta by nemala obsahovať zbytočnú vatu. Napríklad lepším vysvetlením toho, prečo model klasifikoval aktivitu na obrázku ako varenie, je veta: Na obrázku je muž v zástere a drží v ruke varechu. A nie veta: Na obrázku je starší muž so šedivými vlasmi, v ruke drží vyrezávanú varechu hnedej farby, hodiny na stene ukazujú 11 hodín a na stole sú kvety.

Text a schémy Martin Tamajka

Kempelenov inštitút inteligentných technológií

Tento článok je súčasťou série Vysvetliteľná umelá inteligencia: od čiernych skriniek k transparentným modelom.

Projekt podporila Nadácia Pontis.